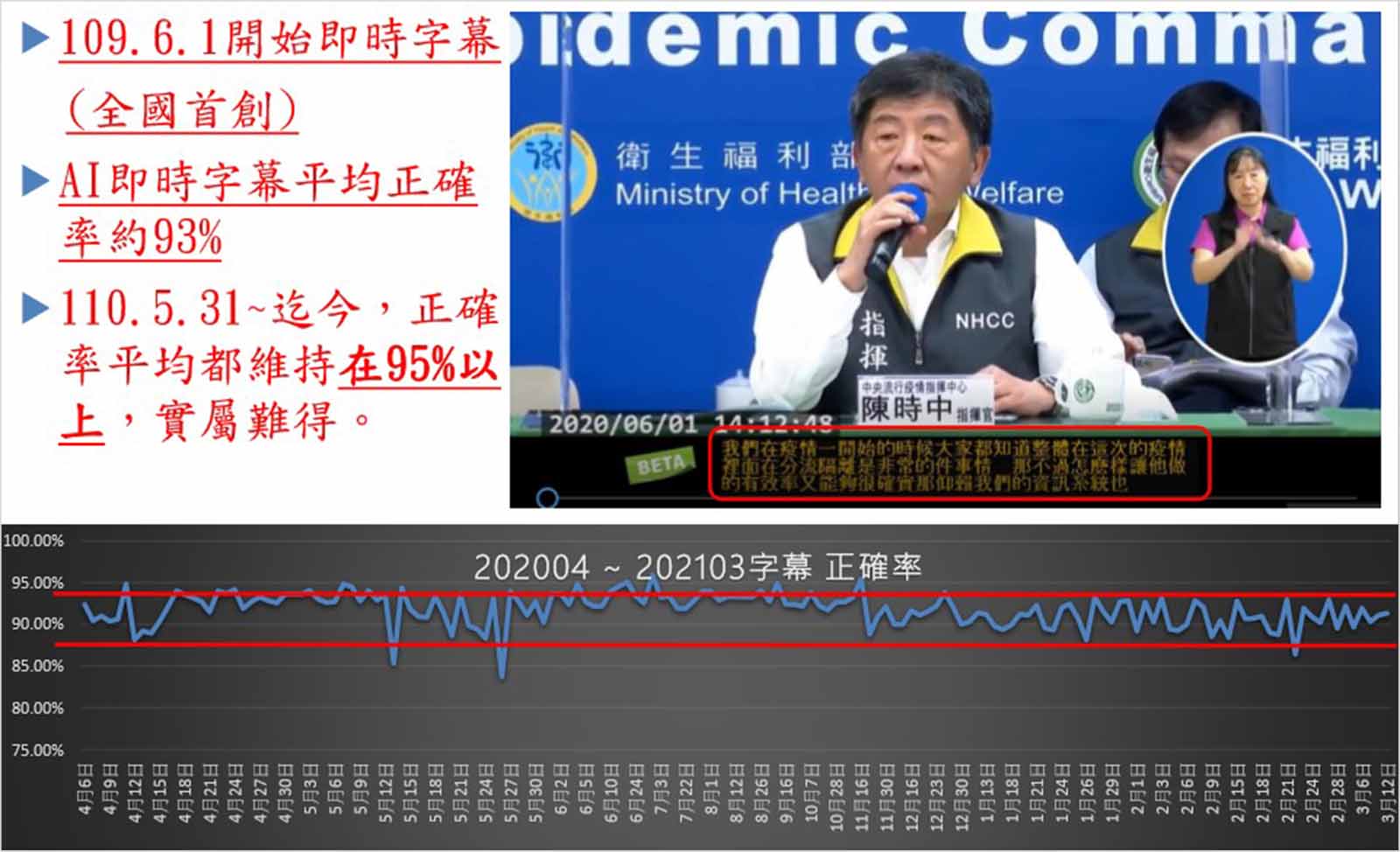

這已成全台灣人的集體行動:每天下午兩點,數千到上萬人打開螢幕等待當天新冠肺炎確認診數。當陳時中一開口,YouTube螢幕下方即時字幕也跟著一字字往前跳;出錯,還會自動退回修改,彷彿字裏行間也有自由意志。

這不是靠聽打員,而是AI語音辨識。

開發者是陽明交通大學網路電信研究中心,由前交大副校長陳信宏領軍,裡面有40多位博碩士工程師。

「為什麼不用AI做?」

去年二月,陽明交大網路電信研究中心指導教授黃紹華在電視上看到,指揮中心每一場記者會配手語老師,靈機一動,「為什麼不用AI做字幕?」

團隊立刻動起來。一開始,先把記者錄音檔用AI轉成字幕;記者會三點結束,人工校正後,五點搭配影片上到YouTube。調校三個月後,即時字幕正式登場,陳時中說的每句話都能轉成文字,同步無時差,正確率達97%。

「台灣人看節目習慣有字幕,許多場合也不適合放出聲音,」網路電信研究中心執行長陳又碩說,AI語音轉文字的應用廣,從節目字幕到立法院會議記錄,它都能做。

前交大副校長陳信宏領軍製作防疫記者會即時字幕,還獲得總統感謝獎牌。圖片來源:SDGs in ECE NYCU、亞洲大學官網

前交大副校長陳信宏領軍製作防疫記者會即時字幕,還獲得總統感謝獎牌。圖片來源:SDGs in ECE NYCU、亞洲大學官網

其實,AI即時字幕系統並非全新服務,它的初登場,是2019年12月28日的總統大選辯論會。

這是台灣選舉史上第一場有字幕的直播辯論,100萬人收看。為替聽打員爭取校正時間,直播訊號特地延遲30秒,打到衛星繞地球一圈再回來;如此,電視觀眾就能看到有AI字幕的完整影片。

那天下午,三位候選人在公視錄影棚激辯;陽明交大團隊與三位聽打員在數十公尺外的公視大樓裡,聚精會神盯著字幕。辯論會前,團隊已多次在其他辯論會蹲點測試,好掌握三位候選人的口音;不料現場仍迸出突發狀況——問題不在口音,而是內容。

原來,語音辨識技術分兩部分——先是聲學,將不同腔調的發音轉成拼音;接著由語言學,將拼音轉換成正確的字詞。

但中文同音字多,AI得靠機率判斷。例如,當人說出句子前三字時,AI就會根據語境,挑出出現機率最高的第四個字。這也是為什麽聊天軟體彷彿有「讀心術」,會自動選出我們常用的詞彙——因為,每一次輸入文字,都在訓練AI更懂我們。

三位候選人中,宋楚瑜字正腔圓,發言中規中舉,AI辨認度百分百,聽打員還能輕鬆喝咖啡;蔡英文其次,聽打員只需偶爾校正。但韓國瑜創意百出的「台灣要當棋子?還是塞子?」、「我談的是大海,你跟我講漱口杯?」名句,充斥非政治領域常用詞,徹底考倒了AI,聽打員只得回歸「工人智慧」,近乎重打。

2020總統大選辯論會直播中,首次導入AI即時字幕系統。圖片來源:截自公視P#新聞實驗室YouTube

2020總統大選辯論會直播中,首次導入AI即時字幕系統。圖片來源:截自公視P#新聞實驗室YouTube

教AI認得寶傑的聲音

韓國瑜的發言還不是最難預測。網路電信研究中心第一次AI字幕技轉,就遇上發音與內容界的雙料大魔王——劉寶傑主持的長青政論節目《關鍵時刻》。

「寶傑講話跟一般人不一樣,他用吼的,很有戲劇效果,」陳又碩解釋,多數人不這樣講話,所以語音辨識行不通。他們只得先讓AI聽完200小時《關鍵時刻》錄音檔做進階練習,才認得了劉寶傑的聲音。

另一個挑戰是知識領域。

不似防疫記者會或政策辯論,《關鍵時刻》主題漫無邊際,號稱「從內子宮講到外太空」;陽明交大團隊為此發展出「客戶自行加詞」的機制——遇到先前沒談過的議題,製作單位可事先將新詞鍵入系統,只要五分鐘,AI就能更新領域專有詞彙,訓練出一個新模型。

「語音輔助最重要的就是更新速度,」陳又碩說。

例如,防疫記者會主題圍繞防疫,內容明確,AI正確率能快速拉高;但疫情瞬息萬變,天天都冒出新詞——「Moderna」中文是啥?「瑞德西韋」又是哪幾個字?連人類都不清楚,人工智慧就會出現同音錯字。所以,工程師得持續蒐集新詞,每週更新模型。

與國際大廠競爭,在地化是優勢

相較於已發展出訂閱服務的中國語音辨識軟體科大訊飛,陽明交大團隊仍在蹣跚學步。

黃紹華分析,中國語音AI超越台灣,靠的是人海戰術與扎實基本功,各省方言資料量大,標註人力更是取之不盡。幸好有經濟部技術處專案支持,陽明交大團隊花了數百萬元向電視台購買3,000小時國、台語音檔,再花上百萬元聽打成文字,才建立了本土語音辨識研究資料庫。

《關鍵時刻》也曾與名氣響亮的科大訊飛與微軟合作,最後為何選了最小的交大團隊?

「AI在地化很重要,否則無法精準,」陳又碩說,語音AI受口音、慣用語影響,無論哪家大公司的AI,初期正確率大約都只有七成。

「七成正確率是沒有意義的,因為還有三成的錯誤要重聽,不如人工打,」黃紹華說。

科大訊飛對中國各省口音辨識度都近乎百分百,唯獨對台灣口音沒輒;而交大團隊正好相反,把韓國瑜的發言丟進AI,正確率約超過科大訊飛24%。

怎麼從七成拉高到接近百分百?兩個決勝點:一是資料量要夠多,二是工程師肯花時間蹲點,陪著客戶慢慢調校。

陽明交大團隊不斷調整AI辨識系統,提升準確率。圖片來源:SDGs in ECE NYCU

陽明交大團隊不斷調整AI辨識系統,提升準確率。圖片來源:SDGs in ECE NYCU

網路電信研究中心有40幾位工程師,許多都是黃紹華任教北科大時期,與北科大電子工程系教授廖元甫教授一路帶上來的本土碩、博士,包括陳又碩。

「台清交腦袋聰明,但北科大肯蹲低,」黃紹華直指技職與大學系統的差異,台灣重論文輕實務,但要做到產業應用,扎實的技術才是根本。

「蹲點,就是做苦工,了解客戶需求、錯在哪裡,然後反覆修正。」陳又碩說。

比如,該說「中國」或「大陸」?敏感或不雅字眼出現時,該以哪些字替代?這些規則都要一一建立;調教了六個月,正確率突破九成,服務才正式上線。

沒有AI字幕時,《關鍵時刻》聽打員只能每天花數小時,辛苦打出一小時節目逐字稿;現在,聽打員只需校正AI的錯誤,幾乎是「節目錄完就打完」。若所有節目都導入AI字幕,估計能為電視台節省一年上千萬的字幕成本。

然而,AI的高效難免使人覺得受威脅。「一開始聽打員是抗拒的,覺得搶他飯碗,」但陳又碩強調,AI做不到100分,最後一哩路還是得讓專業的來。(延伸閱讀|34種可能會被AI取代工作,為什麼「主管」也是其中之一?)

AI太誠實,立委不雅發言全都錄

即便中國AI產品領先,但基於國安考量,有些內容仍不宜上傳到國外雲端,如立法院會議記錄。

因為,不止影像有deepfake(深偽),聲音也能變造。只要搜集一個人20個小時的聲音,就能合成聲音模型,即便細聽也不見得能分辨。今年中,LINE群組就流傳一段長達七分鐘、號稱是立委蔡璧如錄製的防疫偏方,聲音乍聽類似,但本人否認。

立法院公報處很早就想用AI解決問題,無奈委員們發言經常國台語夾雜,對以中文辨識為主的AI很是挑戰。

陳又碩透露,有一位委員口音特別重,音檔無論丟進哪一家語音辨識,都無法產生字幕;唯獨丟進陽明交大的AI,竟然出現了部分語句,合作就此敲定!

過去,立法院公報處每天會收到50小時錄音檔,由40位速記員打成文字後,給立委辦公室確認,三週後再公布在網路上。今年,立法院總質詢開始使用AI字幕,加上速記員校正,過去字幕版要數週後才能在電視國會頻道重播,現在最快一週後就能播出。

只是過程中有個小插曲。以前,貼心的速記員會修飾立委的不雅發言;但AI吃了誠實豆沙包,聽到什麼就產出什麼,部分委員還抱怨公報「品質下降」。

語音辨識的未來

其實,語音辨識演算法30年前就已出現。當年只有早中晚電視新聞,黃紹華得拿著錄音機,每天錄三小時、打成三萬多字後拿去斷詞,再花兩天讓奔騰386電腦來跑。「現在有GPU,一、兩萬小時的資料,機器幾秒鐘就學會了!」

當聲音能即時變成文字,就能做更多產業應用,如語音辨認、語音合成與語音理解,形成語音經濟。

語音辨認如會議記錄、客服品質抽聽,刑事局調查局監聽賄選等;語音合成能將語音資料合成聲音,保留已逝國寶演員、歌手的聲音。這兩種技術都相當成熟,但最後一塊語音理解最難,不只要辨認聲音,還要理解問句意義,給出正確答案,最知名的應用就是Siri。

有一天,會不會無論說出哪種語言,都能直接變中文發音、打出中文字幕?甚至,打在擴增實境的眼鏡上?

或許,AI語音辨識或許都能辦到!(延伸閱讀|大國競逐下的AI新方向,台灣往哪走?四頂尖大學專家:跨域、落地是關鍵)