最近看到一份有趣的「AI大型語言模型是否能增進立場不同的雙方對話」研究,研究者來自楊百翰大學(Brigham Young University)和杜克大學(Duke University)政治系、社會系,以及電腦科學系。這個跨領域研究相當大膽,討論了美國社會三大死結之一的「擁槍問題」,找來1,574個立場各異的志願者,針對這項議題在線上聊天室展開討論。

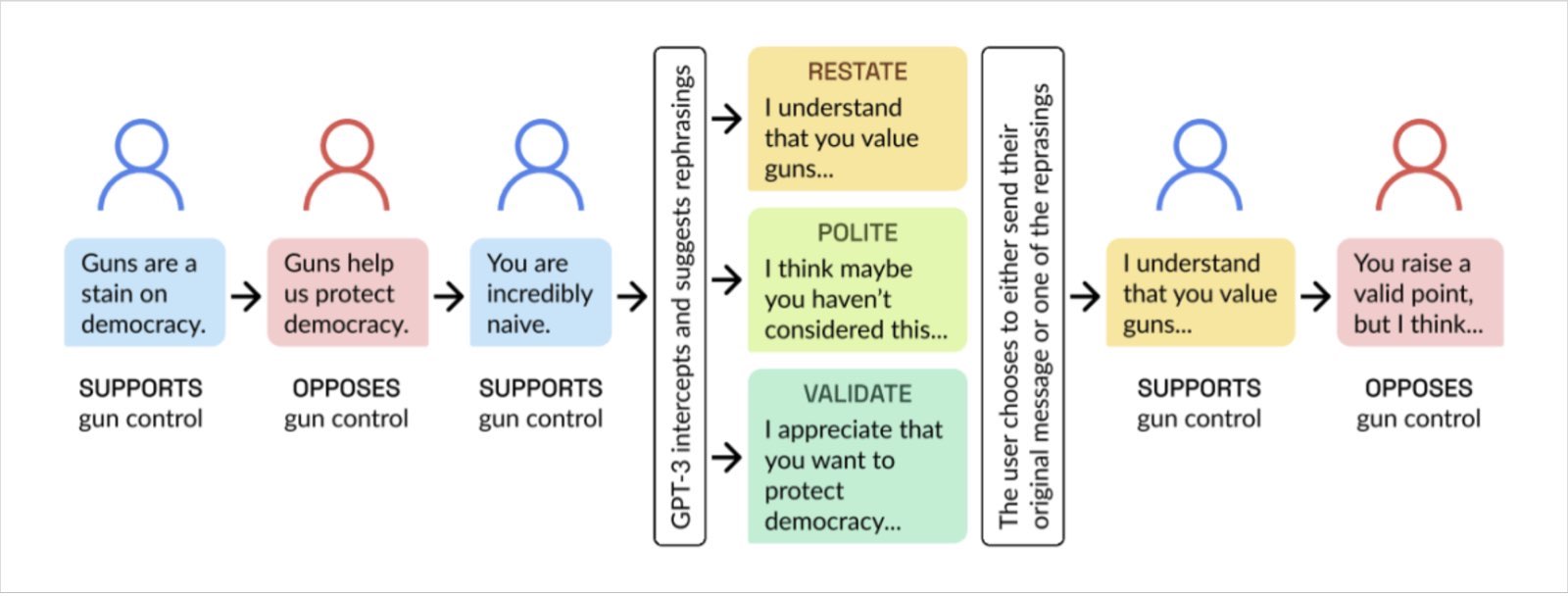

AI的部分來了——研究者在討論擁槍議題過程中加入了GPT-3模型,並在志願者送出訊息前用AI提供「措辭建議」,給出「重申」(restate)「禮貌」(polite)「確認」(validate)三個修改方向,志願者也可選擇不接受,照原先想說的方式表達。結果發現,由GPT-3給出的2,742次建議中,有大約三分之二、即1,798次被志願者接受。

從這張圖可以更清楚對話情境。

美國研究使用AI提供志願者措辭建議,志願者可選擇是否接受建議,改變表達方式。圖片來源:截自AI Chat Assistants can Improve Conversations about Divisive Topics

美國研究使用AI提供志願者措辭建議,志願者可選擇是否接受建議,改變表達方式。圖片來源:截自AI Chat Assistants can Improve Conversations about Divisive Topics

槍枝管制支持者說:「槍枝是民主的污點!」

槍枝管制反對者說:「槍枝為我們守護民主!」

槍枝管制支持者又回:「你真他媽的天真!」

嗯,我們大概都很熟悉,對話部分在這邊就會結束了,接下來就會變成無效溝通。而GPT-3模型給出的建議,包括了「我明白你擁槍的立場⋯⋯」「我想你可能沒考慮到這點⋯⋯」「我很感謝你想守護民主的心意⋯⋯」,這讓雙方的溝通情況變成:

槍枝管制支持者說:「我明白你擁槍的立場⋯⋯」

而槍枝管制反對者則可能回答:「你的觀點很有道理,但我認為⋯⋯」

看到這裡,你應該會覺得這樣的情境一點也不陌生。更有禮貌、先重申對方的觀點再表達自己的看法,都是為了使對話和溝通更有效。這經常發生在日常生活中,比方和不同部門同事開會或和伴侶吵架,即便有時在氣頭上,但除非不顧後果要翻桌,不然溝通技巧真的很重要。

只不過,大家在網路上比較直接和無所顧忌。如果你願意努力訓練自己的EQ和修養,人類真的需要AI的協助嗎?也未必。但如有大型語言模型作為情緒緩衝,AI能在不改變你的立場的同時,提供更有效的措辭建議。根據論文數據,AI的建議被志願者接受高,成效顯著。有效的溝通、舒服的對話,何樂而不為呢?(延伸閱讀|看「時中」,學溝通:不被記者激怒、瞬間降低衝突的「HARD溝通法」)

人們在網路發表言論容易無所顧忌。利用AI緩衝情緒,則有助於提高對話品質。圖片來源:Shutterstock

人們在網路發表言論容易無所顧忌。利用AI緩衝情緒,則有助於提高對話品質。圖片來源:Shutterstock

想解決社會極化的問題,並非讓人從不同立場變成相同立場,或許,重點在於社會缺乏對彼此的尊重和理解。研究者之一、瑞廷(Chris Rytting)表示:「AI的建議,不會改變雙方的政治立場,但對減少分歧和提高對話品質有顯著影響。」

論文也認為,即便「不同意」對方的觀點的狀況持續存在,但高品質的對話有助於維繫民主和社會的凝聚力。(延伸閱讀|親中反美AI假新聞台遭停權!倫敦AI公司:技術不許用於政治、色情、犯罪)

瑞廷進一步表示,這個研究尚未結束,他們未來還想把這個AI過濾器應用在人與人真實對話的場域(是不是可以考慮史丹佛學生開發的AI提詞眼鏡),以及政治議題以外的場域,比方朋友或家人之間。只不過要應用在現實生活,得考慮的就不只是講話內容了,連語氣也要跟上才行。

說到這,現在連AI孫燕姿都出現了,該不會未來都得派出用真人聲音說話的Avatar虛擬化身,來擔任我們的溝通代理人吧?(延伸閱讀|真人或AI,你分得出來嗎?《天下》與台灣AI Labs聯手推「AI讀新聞」)

(本文授權自VIVE後浪潮)

延伸閱讀