勞倫斯・雷席格(Lawrence Lessig)小檔案

- 創用CC(Creative Commons)創始人

- 哈佛大學法學院教授,曾任芝加哥大學法學院教授、史丹佛大學法學院教授並創設網路與社會中心

- 曾獲The New Yorker評為網路世代最重要的智財思想家、威比獎(Webby Awards)、科學美國人50獎、Fastcase50獎等

以下是勞倫斯・雷席格的演講精華:

今天我想探討兩項觀點:AI對法律的影響,以及法律對AI的作用。這兩個問題有兩種不同的答案,一個充滿希望、甚至激勵人心,另一個則可能令人恐懼。

不過,就如同過去所有的科技,AI具有兩面性(Janus-faced),我們必須選擇讓科技的哪一面朝向我們。

雅努斯(Janus)是羅馬神話的「天門神」,兩張面孔分別展望過去與未來。圖片來源:陳芳毓攝

雅努斯(Janus)是羅馬神話的「天門神」,兩張面孔分別展望過去與未來。圖片來源:陳芳毓攝

那麼,AI對法律可能有哪些影響呢?

我認為,每個人都有屬於自己的「AI時刻」(AI moments)。有一次,有人傳來一首AI為我寫的詩。我的AI時刻,就在閱讀這首詩時誕生了!我意識到,這世界上沒有人能針對我的工作寫出如此微妙適切的觀點,更沒有人以這樣的方式讀過我的所有著作。

這更讓我發現,在法律領域,AI具有我們尚未掌握的潛力。

AI能大量閱讀,這是相當難得的潛能。多數法律學者只能處理閱讀過的內容,或學會假裝自己已經閱讀過。畢竟寫作工作繁重,誰還有時間閱讀呢?

我最後一次到美國最高法院辯論,是在COVID-19疫情爆發之初,那是一件關於總統選舉人權力的憲法案件。當天我穿著牛仔褲,坐在辦公室裡,透過ZOOM遠端辯論。答辯書提及1950年代著名的Ray v.s. Blair一案,並在此案上建構論點;但令我震驚的是,有法官根本沒有認真讀完答辯書與案例。

在美國,法律糟透了。在美國,法律很慢、很昂貴、不可及,而且不可靠。法治系統就像是黃金築起的道路,人們必須花費高額代價,才可能接近正義的終點。

在這樣的背景下,我想強調,AI對於實現正義有著巨大的潛力。

AI對法律能做什麼?

當我在思考這項論點時,覺得似曾相識。1999年我在撰寫第一本書《網路自由與法律》(Code and Other Laws of Cyberspace)時,對於網際網路的未來也感到相當矛盾。

概念上來說,我是一個樂觀主義者,可以想像未來的網路世界欣欣向榮;實際上,我是一個悲觀主義者。我認為可能將出現破壞性力量,改變網路空間的發展。

Web3:程式碼即法律,但並非唯一的法律

AI可以改善法治系統,但這不會自動發生。老實說,對於人類能否引導科技走往好的方向,我沒什麼信心。好的情況會是什麼樣子呢?在大型語言模型出現之前,我就已經提出法律在未來網路時代之下的樂觀構想。

這要從Web3開始談起,不過這在今天來說相當危險,因為許多人都認為Web3是一場騙局。我曾到Reddit上詢問,該如何向五歲小孩解釋Web3;但我得到的答案卻是「Web3是一種組織犯罪洗錢的術語」「這是加密貨幣愛好者創造的行銷術語」以及「沒有誠實的生意人會說自己在做Web3」。

這令人非常沮喪。我可以理解,Web3技術因被應用在加密貨幣交易,而存在一些形象問題,但我們應該將Web3視為基礎建設,這是用於實現智慧合約(smart contracts)的重要基礎設施。

Web3是程式碼(code),能更好地處理私法、公法、契約以及各種協議。在書中,我將此論述稱為「程式碼即法律」(code is law)。

許多加密貨幣愛好者喜歡這項論述,因為他們認為如果程式碼即法律,那麼程式碼所做的一切都是被允許的。

而當第一個去中心化組織(DAO)出現時,吸引約1.5億美元的投資,有加密貨幣愛好者發現漏洞後,就從該基金中挪用6,000萬美元(約新台幣19.21億元)。許多人認為,程式碼有漏洞,如果「程式碼即法律」,那麼駭客的行為就是合法的。

這使得程式碼似乎讓偷竊成為可能。但是,程式碼即法律,並不代表程式碼就是唯一的法律。還得有另一個法律在程式後面,告訴你不能偷別人的錢。

另一個問題是,對大多數人來說,程式碼是一部機器,因此人類似乎被排除在「程式碼即法律」的論述之外。

勞倫斯・雷席格強調,「程式碼即法律」不代表程式碼就是唯一的法律。圖片來源:台灣人工智慧學校

勞倫斯・雷席格強調,「程式碼即法律」不代表程式碼就是唯一的法律。圖片來源:台灣人工智慧學校

我認為這正是AI的機會。也許在不久的將來,AI就能作為Web3和法律之間的介面,提供人們理解技術的機會,也讓Web3更可能作為法治系統的基礎設施。

要進一步的說明是,法律就是一部大型語言模型(LLM)。原則上,大型語言模型比司法系統更能把事情做好;因為它可以閱讀一切,能保有寫作品質,還能更準確地判斷一般法律案件。

AI做出的判斷比司法系統更好,而且效率高、成本低,我們只需要保留上訴程序,讓人們在機器出錯時能出手。

我們曾經認為,核能、電力的價格可能會非常便宜,甚至接近免費;同樣地,我們也應該夢想一個「正義」太便宜,以至於不必計費的世界,並在全球法治系統內實現這樣的基礎設施。

AI法治的五大原則與可能威脅

因此我認為,AI與Web3的組合,比起現有法治系統更有效率,可及性也更高。但這種好事不會自動實現,應該明確制定原則,引導AI作為法治基礎設施的運作。

第一,保持公共性。無論透過許可證、補助津貼或授權,都必須保障法律AI技術部分的公共性。另一方面,應該將專有技術視為商品,以促進競爭與創新。

第二,具備可解釋性。AI可以被科學家檢測是否存在偏見、錯誤和不公正,並且不受提供者的限制。

第三,保護因為AI犯錯而受害的人。錯誤的成本由AI系統承擔,訴訟、法律費用甚至時間成本都必須得到補償。

第四,人類始終掌握最高權力。「AI失控」不能構成藉口,當AI出錯時仍須由人類負責。

第五,拒絕被著作權所壓制。許多人認為,AI模型訓練使用了受版權保護的資料,並且稱之為侵權與盜版。

這是完全錯誤的。我們必須牢記,藝術家們並未從極端的版權制度中受益。沒有藝術家會對Spotify說太棒了。大型公司吸收藝術家生產的大多數價值,卻只給予極少的回報,可見極端的版權制度對於創作者不一定有幫助。

若AI使用資料可以免於版權,是否代表我們應該考慮設計特殊的補償機制?當然,我不反對找到賠償創作者的方式,但我不認為應該要靠粗糙的著作權機制。

我的觀點是,如果能落實這五項原則,AI將會相當優秀。但人們能接受這些原則嗎?作為實際的悲觀主義者,我對未來抱持著懷疑,眼前就有不少現實的威脅。

勞倫斯・雷席格指出,AI雖能夠提升司法系統的效率,卻也不可忽視其帶來的威脅。圖片來源:陳芳毓攝

勞倫斯・雷席格指出,AI雖能夠提升司法系統的效率,卻也不可忽視其帶來的威脅。圖片來源:陳芳毓攝

威脅一,美國律師協會已經開始攻擊使用AI降低法律成本的做法。DoNotPay執行長約書亞・布羅德(Joshua Browder)嘗試開發AI律師,協助人們處理交通罰單,美國律師協會卻祭出威脅與報復,試圖阻止AI應用。關鍵在於,人們如果都請AI來幫忙,將會導致律師們一無所獲。

威脅二,科技倫理學者崔斯坦・哈里斯(Tristan Harris)曾說,人們早就在社群媒體上,與AI建立過第一次接觸。AI在社群媒體可能成為仇恨政治的推手,導致不尋常的悲慘事件發生。

2021年一月六日的國會大廈暴動事件,造成一名警察殉職,如果說是Facebook造成這起悲劇也不過分,因為Facebook幫助這群人構建了現實。這些人誠心相信民主被偷走了,站起來試圖改變現狀,但他們錯了。因為AI演算法推送不實訊息到他們眼前,才點燃了他們的熱情參與。

AI並不充滿仇恨,祖克柏也不恨美國,相反地,祖克柏愛著美國。這很重要,因為是不同的愛——企業對於獲利的熱愛,讓他們選擇使用這種方式來推動AI,但是這種愛正在摧毀美國的民主。

所以當人們問我,如果AI接管世界怎麼辦?我會說,AI早就已經接管了。背後沒有陰謀,只是AI與這套商業模式在美國造成了邪惡的結果。

威脅三,《時代雜誌》(TIME)曾刊登一篇文章,呼籲暫停AI科技發展,並指出當AI大幅超越人類智慧後,最有可能的後過,就是地球上每個人都將死去。這不是未來的問題,而是當下的問題。大企業聲稱能控制AI,但我們發現,實際上是AI在控制公司。

2017年,Facebook內部建立「猶太仇恨者」這項廣告受眾分類,因為AI判斷有利可圖,並向這些猶太仇恨者出售廣告。遭到非營利組織ProPublica揭露後,Facebook僅回應,此分類標籤由AI創建,並非人類。

人類還沒學會如何馴服AI,這並不是技術問題,而是治理問題。(延伸閱讀|歐盟草擬新法 規範生成式AI工具須揭露版權素材)

法律能對AI做什麼?

來到第二個問題,法律能對AI做些什麼?首先,我們必須先知道,也許法律對AI無能為力。

過去十年來,Google等公司在美國投入大量資源進行訴訟與研究,主張〈憲法第一修正案〉保護言論自由的原則,應同樣適用於演算法。演算法是某種形式上的言論。就像《紐約時報》(New York Times)如何調整報紙版面,也是編輯的選擇,假如試圖監管編輯的選擇,就明顯違憲;在此觀點下,監管演算法也是違憲的。

AI不應受憲法言論自由保障

這是目前美國國內非常強而有力的法律論點,但這不應該是這樣。我們應該將AI視為人類的複製品(replicant),如同《銀翼殺手》(Blade Runner)描述的那樣——人工智慧由人類所創造,但已經超出了人類所能控制的範圍。

當Facebook演算法分出「猶太仇恨者」這個標籤時,這並不能代表祖克伯的想法,而是人工智慧,這是人類的複製品。因此,我認為AI發表的言論不應受到憲法保障。

一個有趣的案例是,一位在美國合法居住的非美國公民,可以出資支持或反對參政的候選人嗎?法院的答案是不行。

大法官指出,美國最高法院已經劃定一條公平明確的界線,政府可以排除外國公民參與民主自治活動。因為外國公民不符合「民主自治」的前提,不屬於美國的一部分,因此法律不能保障外國公民以捐款方式表達言論自由。

重點在於,如果連在華盛頓特區合法居住的真人,都不算是「我們」的一部分,那麼AI也不是。我們需要接受這一點。這聽起來可能有點可怕,但我會大膽地說出來,我們在這裡必須成為「物種主義者」(speciest)。

我們會看著複製人說,是的,你不應該被當作機器對待。我支持給予複製人權利,但這應該是我們的選擇,而不是由1789年憲法制定者決定。我樂意盡我所能保護人們的言論自由,但並不包括AI。

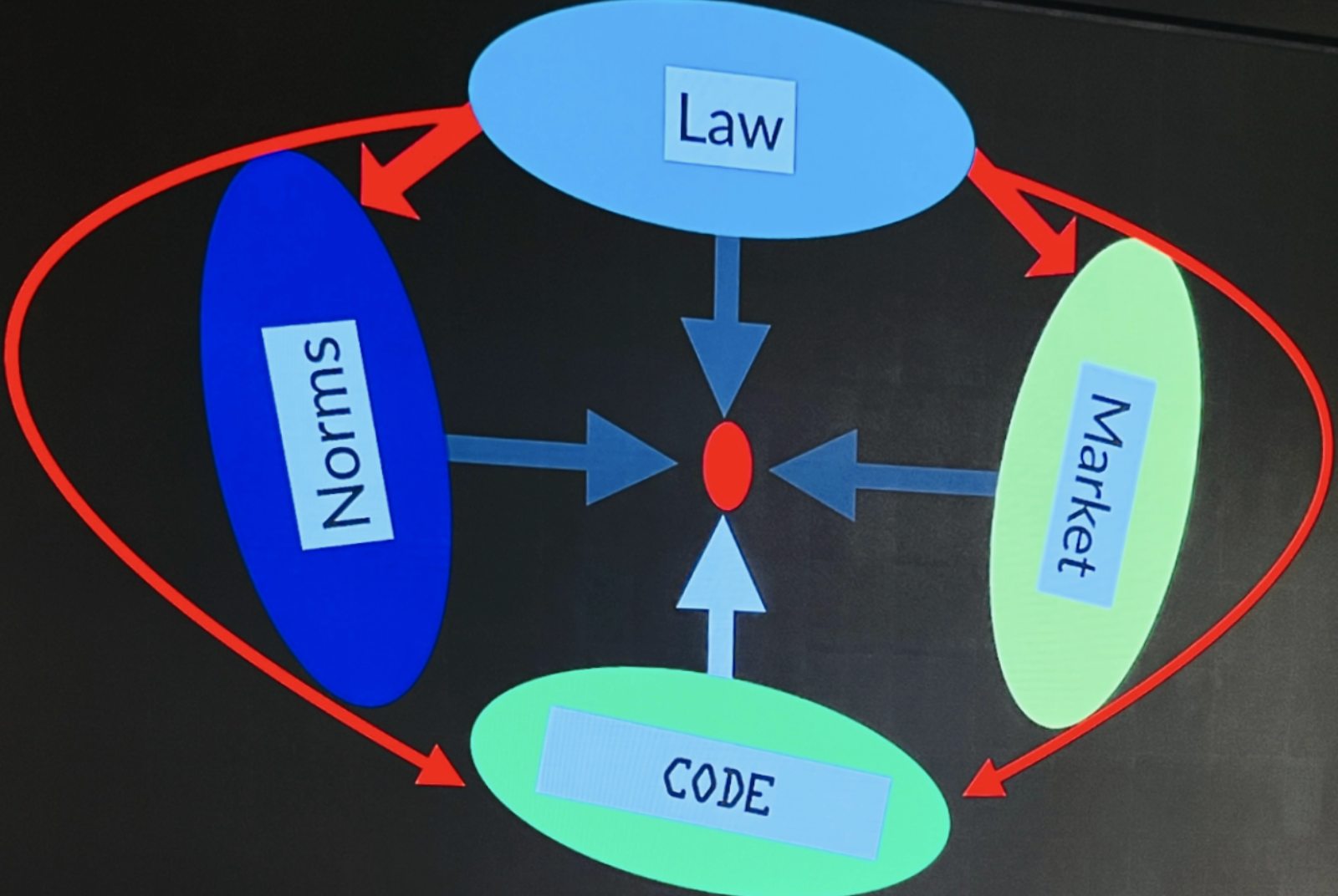

監管理論模型:Pathetic Dot Theory

如果〈憲法第一修正案〉並未完全保護演算法,那我們又應該如何規範AI?許多人對於通用型人工智慧(Artificial General Intelligence, AGI)懷抱恐懼,甚至有調查指出,開發者認為通用型AI有10%機會成為人類存在威脅。

勞倫斯・萊斯格在書中提出「Pathetic Dot Theory」,解釋個人生活如何受到法律、社會規範、市場與科技基礎設施等四種面向調節。圖片來源:許靜之攝

勞倫斯・萊斯格在書中提出「Pathetic Dot Theory」,解釋個人生活如何受到法律、社會規範、市場與科技基礎設施等四種面向調節。圖片來源:許靜之攝

想像AI是位在中心的紅點,我相信法律(Law)一定會產生影響,但隨著開源AI的釋出,等到Meta發表Llama 4或Llama 5的時候,法律的監管可能將顯得十分微不足道。

如果從社會規範(Norms)下手,像是Google一樣,把「Don't be evil」的原則告訴給所有開發者,讓所有人都能安全使用AI。不過,正如Facebook吹哨者弗朗西斯・豪根(Frances Haugen)所言,Facebook內部有許多正派的工程師,但是他們的努力經常被商業模式或市場否決,所以只仰賴規範,依然太天真。市場總是吃掉文化。

從市場(Market)端思考,或許可以參考二次循環稅的概念,業者使用愈多,就得繳愈高的鉅額稅金。當然這還需要立法,而且我不認為大家能相信,市場會以積極明智的方式介入。

接下來,就有了對程式碼(Code)進行規範的想法。只要監管數家IC設計與晶圓代工企業,似乎就能避免這些支撐AI運算的晶片造成毀滅性後果,我們正處於AI的奧本海默時刻(Oppenheimer moment)。

奧本海默(Robert Oppenheimer)在二戰時期負責管理美國曼哈頓計劃,完成第一顆原子彈的開發。他對核子武器充滿擔憂,並認為美國作為原子彈生產者,可以引領放棄核武的運動,讓人類免於核子戰爭的威脅,但美國政府對此不感興趣。

這正是我們目前面臨的威脅,我們看見干預和採取行動的機會,避免在我們無法控制的情況下擴散。(延伸閱讀|AI專家李飛飛來台演講全記錄:使AI見人所不見——如何兼顧安全與隱私?)

勞倫斯・雷席格表示,AI的奧本海默時刻,考驗人們如何將AI威脅降到最低。圖片來源:台灣人工智慧學校

勞倫斯・雷席格表示,AI的奧本海默時刻,考驗人們如何將AI威脅降到最低。圖片來源:台灣人工智慧學校

規範程式碼的三種可能

那麼,我們應該怎麼做?

許多人認為,我們應該強制監管晶片,在晶片上放置限流器,並以程式碼管理晶片,讓程式碼直接成為晶片的法律。

但是,這將讓所有人都非常焦慮。我們該如何治理這種治理?誰來決定何時打開限流器?更令人沮喪的是,如果我們走上這條路,是否就要禁止開源?所有晶片、每部設備甚至每支手機,都要受到管理機構的控制嗎?

首先,同樣面對此難題的唐鳳認為,答案並非監管晶片,而是加強網路安全。雖然聽起來不錯,不過資安支出也將大幅提升30倍。如果我們可以負擔30倍以上的資安預算,也許不需要監管晶片、也不用禁止開源,就能避免災難性的情景發生。

第二個選擇,則是改變這些AI模型背後的預設。19世紀默克(Merck)等大型藥廠在市場販售的處方藥被發現有毒時,假設藥廠的目的是想要害人,是一種愚蠢的監管方式。

到了20世紀,人們學會扭轉假設,藥廠必須先證明他們的藥品有效、安全且無害,才能投入市場。你可以想像類似的情況,如果大型AI演算法要得到許可,需要先證明其安全性,並確保在AI失控時能踩下煞車,這是一種侵入性較小的監管結果。

最後一種選擇,是我們應該思考如何以最低限度減緩AI發展的速度。

我們現在就在這輛車上,很多人對我尖叫,說煞車是侵犯基本權利的行為。大型企業認為,自己有權以最快的方式比賽,否則將無法有效與對手競爭。

但這關乎這個社會的關鍵風險,我們應該依照人類可控的水準來發展AI。因此,我認為至少應該將開發速度減慢,慢到接近於人類目前的認知程度。(延伸閱讀|「我是在做好事?還是一件很壞的事?」ChatGPT之父奧特曼的告白)

兩個大哉問的解答互相矛盾嗎?

今天我提出兩個方向的問題,第一個答案是我們應該讓AI參與法治系統,甚至讓AI取代律師;第二個答案則是在確保AI的安全之前,我們應讓它保持沉默。

這兩個觀點看似矛盾,但我想為此提出說明。

首先,這兩者之間有著規模上的差異。出現在Web3上的AI應用,將是小型、去中心化和自主的複製人,並不會接管世界;但是通用型AI不易維護,我認為相當不同。

第二,法律太可怕了。任何有效的救濟措施都應被視為是安全的,而且比現有的機制都還要好。我們應該承擔風險,無論風險是什麼。

第三,我要提到亞倫・斯沃茲(Aaron Swartz),一個令人難以置信的天才,年僅13歲時就協助開發RSS,他還是CC創用介面設計師、參與開發Markdown,也是Reddit早期開發者之一。

亞倫・斯沃茲曾參與RSS、Markdown與Reddit等技術開發工作。圖片來源:維基百科

亞倫・斯沃茲曾參與RSS、Markdown與Reddit等技術開發工作。圖片來源:維基百科

亞倫・斯沃茲有著強烈倫理道德的影響力,當你認識他、與他交談後,你不自覺地質疑自己正在做的一切。16年前,亞倫問我,「政治體制依舊如此腐敗,你認為你能在網路和版權問題上取得進展嗎?」

我回答,政治系統並不是我的研究領域。接著,他又問:「那作為公民呢?作為公民,這是你的責任領域嗎?」那一刻讓我意識到,他說得對。

如果在接下來的20年裡,我依然只專注在狹隘的版權政策領域,但我們身後的體制沒有進步,所有的政策都將受到阻礙,沒有任何改革能被實現。

那天晚上我向他承諾,我會開始採取行動,不再僅止於研究版權或網路監理政策。我們合作過一段時間,後來他有了新的點子,想向全世界開放學術研究,2011年1月因為從J-score下載文章而被逮捕。

有人聲稱亞倫將在黑市上出售這些文章,好像哈佛法律評論的文章在黑市上有價值一樣。亞倫的意圖是什麼,沒人知道;但他們的理論是,他打算「解放」這些科學文獻,而這是一項該起訴的罪行。檢察官自豪地宣稱,將對他的行為要求判處35年監禁。

在經歷兩年抗爭後,亞倫結束了自己的生命。如果亞倫今天在這裡,我們問他對於AI的討論有什麼看法?他的回答應該跟我今天的演講內容相似,只是每次他提到網路(Internet)時,可以將其替換為AI。

世界上有兩種極端的觀點,網路很棒,或是網路很糟。事實上,兩者都是對的,網路既帶來好處,也帶來壞處,兩者都令人驚嘆不已,但是何者將勝出,取決於我們。

好與壞永遠都會存在,我們身處在沒有答案的時刻,也正是充滿希望的時刻。我們可以再次學習如何做選擇。(延伸閱讀|如何站上AI巨人肩膀?台灣的六個應變策)